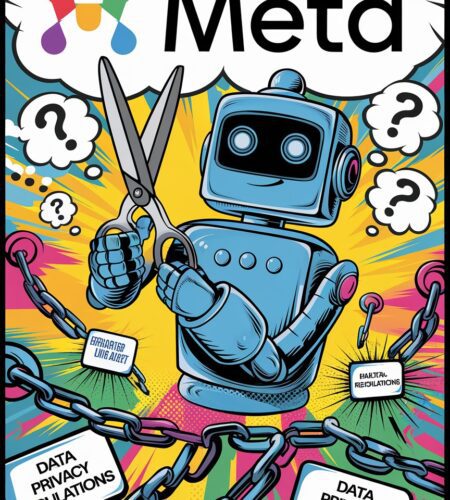

Dans une quête effrénée pour rester à la pointe de l’innovation en intelligence artificielle, Meta vient d’annoncer une réforme majeure de son processus de sécurité des données. Après des années de contrôles stricts suite à divers scandales comme Cambridge Analytica, le géant des réseaux sociaux a décidé d’alléger ses régulations internes pour accélérer le développement de ses technologies d’IA. Mais à quel prix pour la confidentialité et la sécurité des utilisateurs ?

Meta Passe La Seconde Sur L’IA

Selon des informations rapportées par The Information, Meta a informé son personnel d’un changement de cap : l’influence des préoccupations de confidentialité sera réduite dans les lancements de produits, tandis que les décisions passées basées sur ces mêmes critères seront réévaluées. Concrètement, les équipes produits auront le dernier mot sur les risques de confidentialité acceptables, et non plus les équipes dédiées à la protection des données.

Ce revirement stratégique intervient alors que Meta avait justement rappelé le mois dernier les 8 milliards de dollars investis dans des initiatives liées à la confidentialité depuis 2019. Mais face à l’intensification de la concurrence sur l’IA, avec des acteurs chinois comme DeepSeek qui développent des modèles à un rythme effréné et à moindre coût, Meta semble vouloir revenir à son approche initiale du « move fast and break things ».

Les Leçons De Cambridge Analytica Oubliées ?

C’est pourtant le scandale Cambridge Analytica qui avait forcé Meta à revoir sa copie en matière de protection des données. Rappelons que cette affaire avait éclaté en 2018, révélant qu’une firme britannique avait eu accès aux données de millions d’utilisateurs Facebook à leur insu, à des fins de profilage politique. Un tournant qui avait valu à Meta une amende record de 5 milliards de dollars de la part de la Federal Trade Commission américaine.

Suite à cela, Meta avait dû mettre en place tout un arsenal de régulations internes : restrictions d’accès à l’API pour les développeurs tiers, contrôles renforcés, comités d’éthique… Des mesures nécessaires au vu des failles béantes révélées par le passé, qui avaient permis à des groupes malveillants de détourner les données des utilisateurs de Facebook et Instagram.

L’Europe Sonnera-t-elle l’Alarme ?

Au-delà des États-Unis, c’est aussi en Europe que Meta a dû rendre des comptes sur sa gestion des données personnelles. Le RGPD, entré en vigueur en 2018, a donné lieu à plusieurs sanctions à l’encontre de l’entreprise pour non-respect des règles de consentement et de transparence. Avec ce relâchement annoncé des contrôles internes, Meta s’expose à de nouveaux risques de non-conformité.

Nous avons investi plus de 8 milliards de dollars dans notre programme de confidentialité qui garantit que nous prenons en compte les risques à chaque étape du processus de développement des produits. Nous continuerons à le faire de manière efficace tout en respectant nos obligations réglementaires.

Meta, en réponse aux allégations

Reste à voir si ces garanties suffiront à rassurer les régulateurs européens, qui n’ont pas hésité par le passé à sanctionner lourdement les manquements du géant américain en matière de protection des données.

Faut-il Sacrifier La Sécurité Sur L’Autel De L’Innovation ?

Mark Zuckerberg n’a jamais caché sa préférence pour un mode de fonctionnement privilégiant l’innovation à tout prix, quitte à essuyer les plâtres ensuite. Une approche qui a fait le succès de Facebook à ses débuts, mais qui a aussi montré ses limites avec les dérives constatées ces dernières années sur les réseaux sociaux en termes de désinformation, de discours haineux ou de détournement des données personnelles.

Dans la course à l’IA qui s’intensifie, avec l’émergence de modèles « super-intelligents » comme ChatGPT, on peut comprendre la tentation de vouloir aller plus vite et casser les barrières. Mais faut-il pour autant réduire la voilure sur les garde-fous éthiques et les vérifications de sécurité, au risque de répéter les erreurs du passé ?

Quelle Responsabilité Pour Les Géants De La Tech ?

Au-delà de Meta, c’est toute l’industrie technologique qui est confrontée à ce dilemme entre rapidité d’innovation et responsabilité éthique. À l’heure où les gouvernements s’inquiètent des effets néfastes des réseaux sociaux sur les plus jeunes et envisagent de durcir les législations, notamment sur les limites d’âge, est-il raisonnable d’accélérer le développement d’IA toujours plus puissantes et intrusives ?

Meta a déjà montré par le passé sa propension à collecter un maximum de données personnelles pour entraîner ses algorithmes, que ce soit à travers ses casques VR, ses chatbots ou ses multiples applications. Avec des contrôles allégés, le risque est grand de voir ces pratiques s’intensifier, sans véritable considération pour le consentement éclairé des utilisateurs.

Quel Avenir Pour L’IA Éthique Et Responsable ?

La décision de Meta de desserrer la bride sur la confidentialité au profit de l’innovation en IA soulève de nombreuses questions :

- Comment s’assurer que les données personnelles des utilisateurs seront protégées et utilisées de manière éthique ?

- Quels mécanismes de contrôle indépendants mettre en place pour auditer les pratiques des géants de la tech en matière d’IA ?

- Comment responsabiliser les entreprises sur les conséquences sociétales de leurs choix technologiques ?

Autant d’enjeux cruciaux pour l’avenir de l’IA, qui nécessiteront une coopération étroite entre pouvoirs publics, société civile, chercheurs et acteurs industriels. Car si l’innovation est essentielle au progrès, elle ne peut se faire au détriment de l’éthique et des droits fondamentaux des citoyens. C’est tout l’équilibre à trouver pour faire de l’IA une technologie au service de l’humain, et non l’inverse.

Abonnez-vous à notre newsletter pour recevoir les derniers articles directement dans votre boîte mail.

Commentaires